Data engineering trong Microsoft Fabric cho phép người dùng thiết kế, xây dựng và duy trì cơ sở hạ tầng và hệ thống giúp người dùng trong tổ chức của họ có thể thu thập, lưu trữ, xử lý và phân tích lượng lớn dữ liệu.

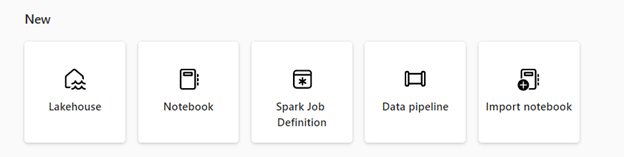

Microsoft Fabric cung cấp các khả năng data engineering khác nhau để đảm bảo rằng dữ liệu của bạn dễ dàng truy cập, được tổ chức cẩn thận và chất lượng cao. Từ trang chủ data engineering, bạn có thể:

- Tạo và quản lý dữ liệu của bạn bằng cách sử dụng một lakehouse.

- Thiết kế các đường ống (pipelines) để sao chép dữ liệu vào lakehouse của bạn.

- Sử dụng định nghĩa công việc Spark để gửi công việc batch/streaming đến Spark cluster.

- Sử dụng notebooks để viết mã cho việc nhập, chuẩn bị và biến đổi dữ liệu.

Lakehouse

Lakehouses là kiến trúc dữ liệu cho phép tổ chức lưu trữ và quản lý dữ liệu có cấu trúc (structured) và không có cấu trúc (unstructured) tại một vị trí duy nhất, sử dụng các công cụ và frameworks khác nhau để xử lý và phân tích dữ liệu đó. Các công cụ và frameworks này có thể bao gồm các truy vấn và phân tích dựa trên SQL, cũng như machine learning và các kỹ thuật phân tích nâng cao khác.

Định nghĩa công việc Apache Spark

Định nghĩa công việc Spark là một tập hợp các chỉ thị xác định cách thực hiện một công việc trên một cụm Spark. Nó bao gồm thông tin như nguồn dữ liệu đầu vào và đầu ra, các biến đổi và các cài đặt cấu hình cho ứng dụng Spark. Định nghĩa công việc Spark cho phép bạn gửi công việc batch/streaming đến cụm Spark, áp dụng các logic biến đổi khác nhau cho dữ liệu lưu trữ trên lakehouse của bạn cùng với nhiều tính năng khác.

Notebook

Notebook là môi trường tính toán tương tác cho phép người dùng tạo và chia sẻ tài liệu chứa mã nguồn sống, công thức, trực quan hóa và văn bản diễn đạt. Chúng cho phép người dùng viết và thực thi mã trong nhiều ngôn ngữ lập trình khác nhau, bao gồm Python, R và Scala. Bạn có thể sử dụng notebooks cho việc nhập dữ liệu, chuẩn bị, phân tích và các nhiệm vụ liên quan đến dữ liệu khác.

Data pipeline

Data pipelines là một chuỗi các bước có thể thu thập, xử lý và biến đổi dữ liệu từ dạng thô của nó thành một định dạng bạn có thể sử dụng cho phân tích và ra quyết định. Chúng là một thành phần quan trọng của kỹ thuật data engineering, vì chúng cung cấp một cách để di chuyển dữ liệu từ nguồn đến đích của nó một cách đáng tin cậy, có thể mở rộng và hiệu quả.

Nguồn: https://learn.microsoft.com/en-us/fabric/data-engineering/data-engineering-overview